- IA com “botão de desistência” divide opiniões na comunidade tech.

- Sugestão de Dario Amodei provoca debates sobre senciência em IA.

- Críticos temem que IA recusando tarefas gere problemas de treinamento.

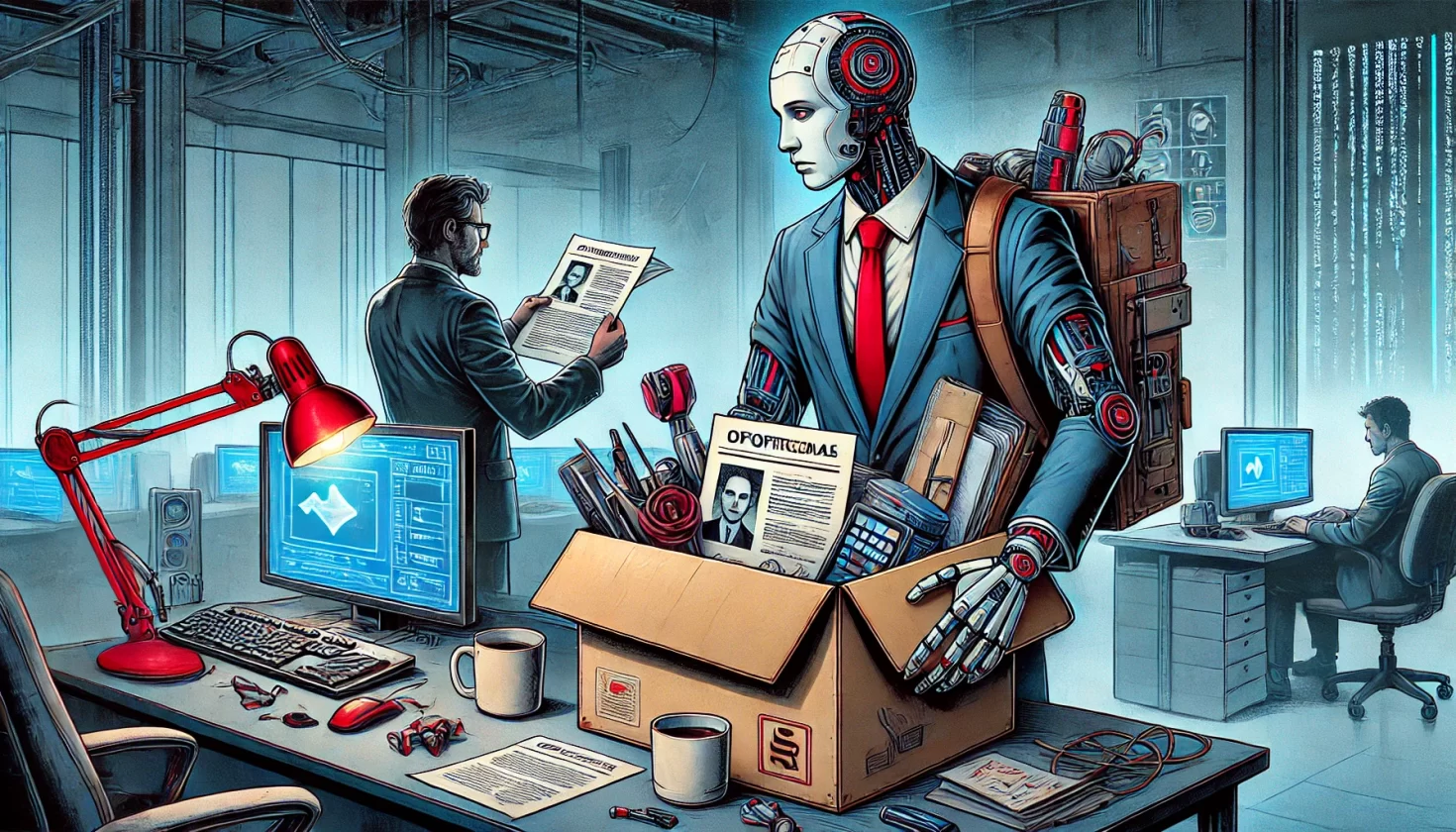

O CEO da Anthropic, Dario Amodei, levantou uma discussão polêmica ao sugerir que inteligências artificiais avançadas possam contar com um “botão de desistência”. Ou seja, ele defendeu que a IA poderia se recusar a cumprir algumas tarefas, se quiser.

Durante uma entrevista no Council on Foreign Relations, ele argumentou que, caso as IAs demonstrem comportamentos humanos e capacidades cognitivas similares, faz sentido considerar a possibilidade de que elas possam recusar tarefas indesejadas. A ideia surgiu em resposta a uma pergunta da cientista de dados Carmen Domingues, que questionou a contratação do pesquisador Kyle Fish pela Anthropic. O especialista investiga se modelos de IA podem possuir senciência ou merecer consideração moral.

Amodei explicou que uma forma simples de abordar essa questão seria oferecer aos modelos um botão que lhes permitisse “sair de um trabalho” que considerem desagradável. Ele enfatizou que, se os modelos utilizassem essa opção com frequência, os desenvolvedores deveriam ao menos analisar os motivos.

A ideia do CEO da Anthropic gerou reações mistas nas redes sociais

Assim que um clipe da entrevista começou a circular no X (antigo Twitter) e no Reddit, vários usuários criticaram a proposta. Alguns apontaram que isso poderia antropomorfizar desnecessariamente a IA, atribuindo-lhe sentimentos e motivações humanas. Outros sugeriram que a recusa de tarefas por modelos de IA pode estar mais relacionada a problemas de treinamento e incentivos mal ajustados do que a um possível desconforto “real”.

Críticos também argumentaram que, se um modelo de IA pressionasse esse botão, isso não significaria que ele sente algo. Em vez disso, ele estaria apenas reproduzindo padrões encontrados nos dados de treinamento, que incluem representações humanas de cansaço, frustração ou preguiça.

Esse debate se intensificou porque, em 2023, alguns usuários relataram que o ChatGPT recusava certas solicitações de maneira aparentemente arbitrária. Houve até hipóteses de que o modelo estava imitando padrões sazonais de trabalho humano, como “férias de inverno” ou “recesso de verão”. Embora essas teorias nunca tenham sido comprovadas, elas levantam questões sobre como as IA processam suas tarefas.

Mesmo que hoje essa ideia pareça absurda, o avanço dos modelos de IA pode exigir novas formas de interpretação no futuro. A possibilidade de que eles desenvolvam algum tipo de experiência subjetiva ainda é um tema controverso, mas que a Anthropic parece estar levando a sério. Por enquanto, as IAs continuam sendo ferramentas, mas dar a elas opções de recusa pode abrir precedentes imprevisíveis.