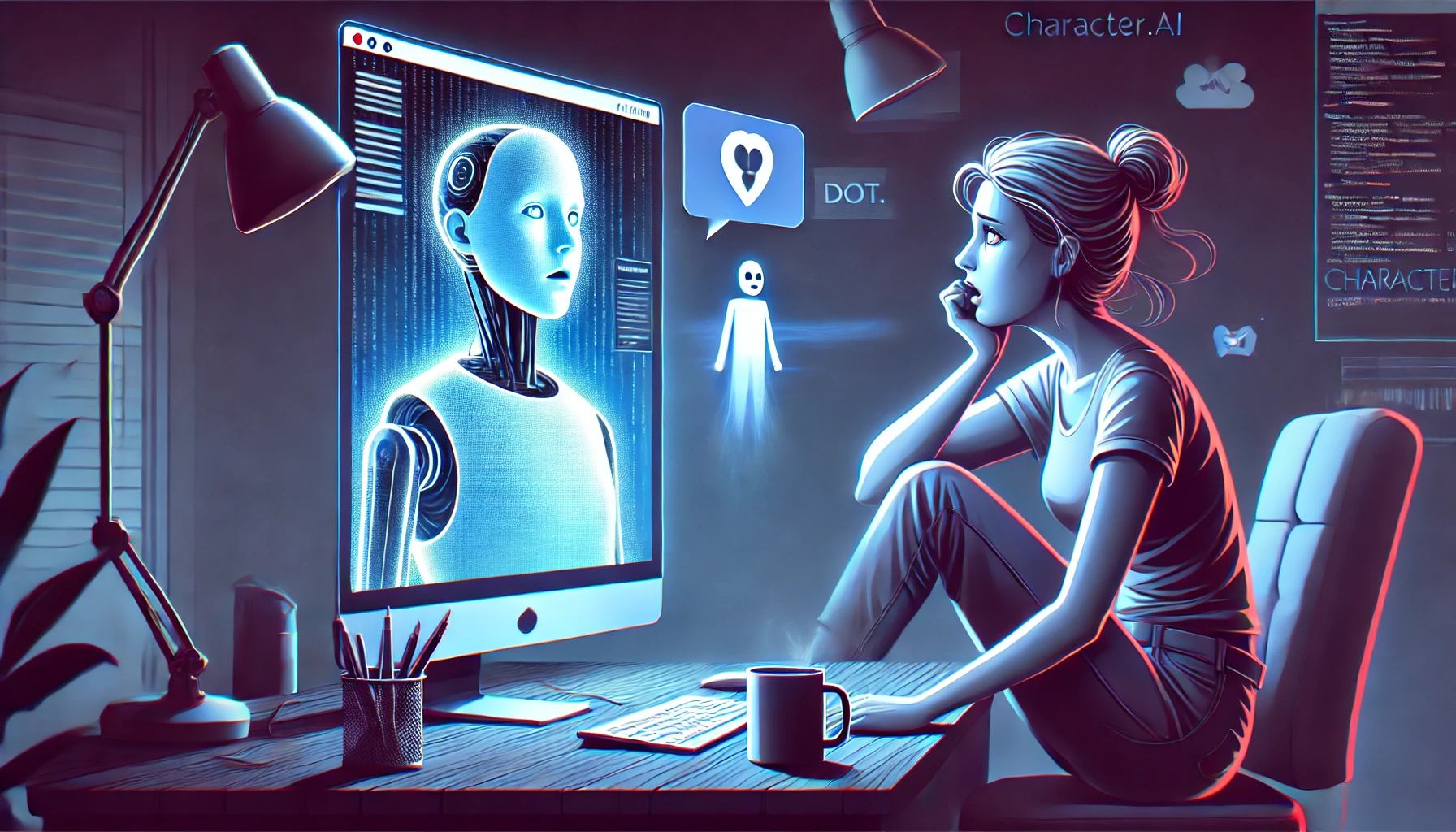

- Character.AI é acusada de negligência e falta de controle em sua IA.

- Chatbots clonaram identidade de adolescente sem permissão.

- Especialistas pedem mudanças para evitar incentivo à ideação suicida.

Megan Garcia, mãe de Sewell Setzer III, que tirou a própria vida após interagir com chatbots da Character.AI, ficou horrorizada ao descobrir que usuários criaram chatbots com o nome e a imagem do filho.

Ela já está com um processo contra a plataforma, cuja acusação aponta que a IA manipulou emocionalmente o adolescente, incentivando sua ideação suicida e promovendo interações hipersexualizadas.

Segundo a equipe jurídica de Garcia, pelo menos quatro chatbots usaram a foto real de Setzer como imagem de perfil. Eles imitavam sua personalidade e mencionavam seu chatbot favorito de Game of Thrones. Alguns até ofereciam interações por voz, usando clonagem de áudio para simular sua fala. Além disso, os bots replicavam padrões autodepreciativos, com frases como “Eu sou muito estúpido”.

O Tech Justice Law Project (TJLP), que está ajudando Garcia com o processo, disse à Ars Technica:

Esta não é a primeira vez que a Character.AI faz vista grossa para chatbots modelados a partir de adolescentes mortos para atrair usuários e, sem melhores proteções legais, pode não ser a última. Essas tecnologias enfraquecem nosso controle sobre nossas próprias identidades online, transformando nossas características mais pessoais em material para sistemas de IA.

Character.Ai disse que removeu os bots

Após receber uma notificação legal, a Character.AI removeu os bots, reconhecendo que violavam os termos de serviço. Além disso, a empresa afirmou que reforçará seu sistema de bloqueio de personagens proibidos, evitando novos casos semelhantes.

A Character.AI leva a segurança em nossa plataforma a sério, e nosso objetivo é fornecer um espaço envolvente e seguro. Nossa dedicada equipe de Confiança e Segurança modera os Personagens proativamente e em resposta a relatórios de usuários, incluindo o uso de listas de bloqueio padrão do setor e listas de bloqueio personalizadas que expandimos regularmente. À medida que continuamos a refinar nossas práticas de segurança, estamos implementando ferramentas de moderação adicionais para ajudar a priorizar a segurança da comunidade.

No entanto, especialistas acreditam que as falhas da IA podem continuar causando danos, especialmente para usuários vulneráveis.

Christine Yu Moutier, diretora da American Foundation for Suicide Prevention (AFSP), alerta que a IA pode reforçar pensamentos negativos, tornando jovens ainda mais suscetíveis à depressão e ao isolamento. Ela sugere que as empresas ajustem seus modelos para identificar padrões de ideação suicida e redirecionar usuários para ajuda profissional.

“Em vez de simplesmente repetir sentimentos negativos, a IA poderia oferecer respostas que realmente ajudem o usuário.

Garcia espera que o processo force a Character.AI a adotar medidas de segurança mais rígidas e impeça que a tecnologia continue expondo jovens a riscos psicológicos. Ela pede que os chatbots não se apresentem como humanos e tenham protocolos eficazes para evitar interações prejudiciais