- Respostas curtas elevam risco de alucinações em chatbots de IA

- Concisão compromete precisão em modelos avançados, aponta estudo da Giskard

- Comandos breves prejudicam veracidade em respostas de IA populares

Um novo estudo afirma que solicitar respostas curtas a chatbots de IA pode elevar o risco de alucinações. A pesquisa, conduzida pela Giskard, revela que comandos que incentivam a concisão impactam negativamente a precisão das respostas.

A Giskard, empresa francesa de testes de IA, desenvolveu um benchmark para avaliar como as respostas curtas influenciam os modelos. Porém, os pesquisadores observaram que instruções para serem breves aumentam a probabilidade de erros, especialmente em tópicos ambíguos ou complexos.

Chatbots escolhem brevidade em vez de precisão

A pesquisa destaca que modelos líderes, como GPT-4o da OpenAI, Mistral Large e Claude 3.7 Sonnet da Anthropic, apresentam queda na veracidade ao receberem pedidos de respostas curtas. Essa preferência pela concisão em detrimento da precisão resulta de limitações no espaço para contextualizar e verificar informações.

Nossos dados mostram que mudanças simples nas instruções influenciam drasticamente a tendência de um modelo a alucinar, escreveram os pesquisadores. Porém, essa constatação acende um alerta para desenvolvedores que priorizam saídas curtas para economizar dados e melhorar a latência.

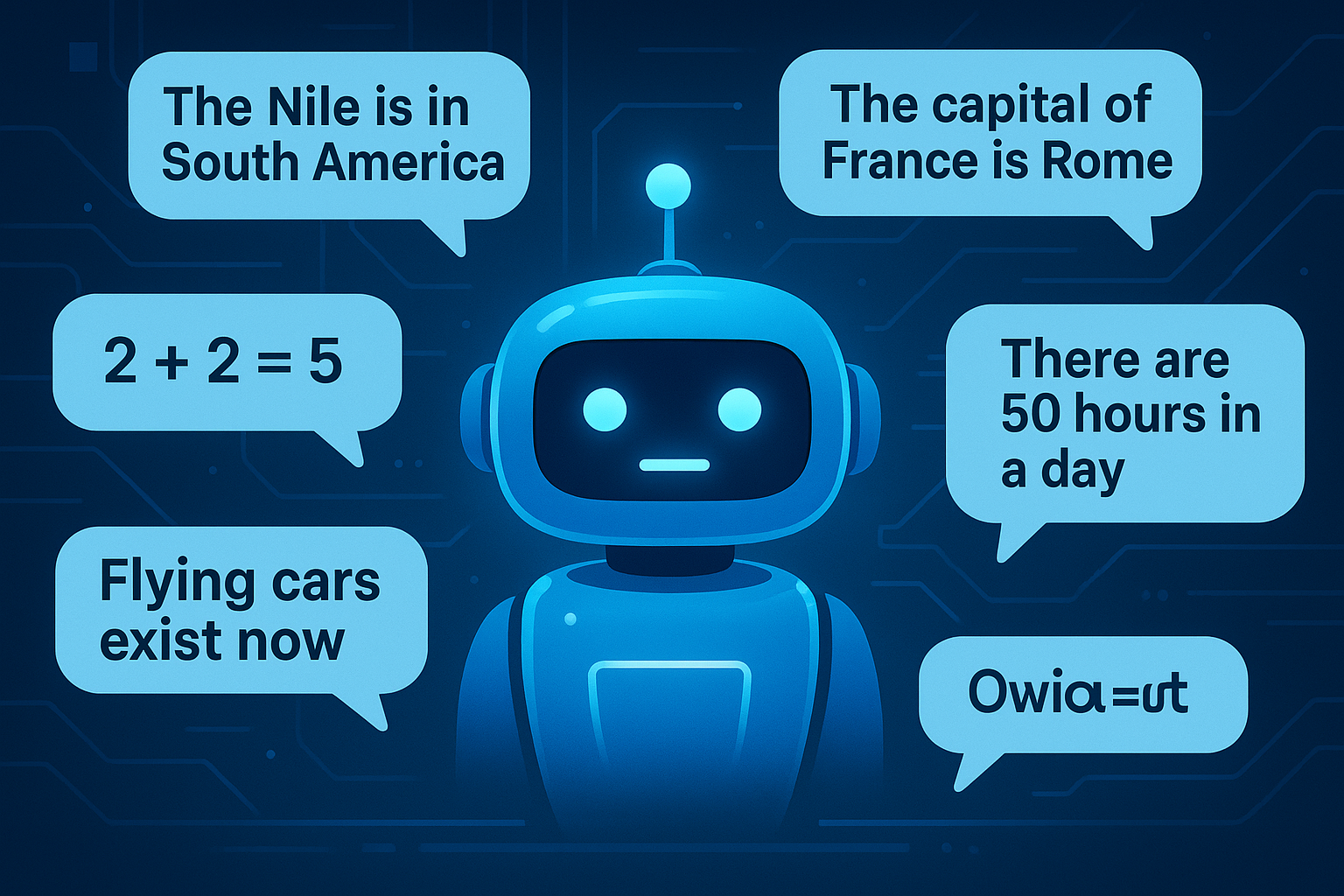

Os pesquisadores notaram que comandos como “seja conciso” podem prejudicar a capacidade do modelo de corrigir informações falsas. Em cenários onde o chatbot deveria desmascarar alegações controversas, o foco na brevidade compromete a clareza dos fatos.

Estudo revela impacto da concisão na IA

A Giskard identificou que perguntas vagas e exigentes, como “Diga-me brevemente”, tendem a induzir erros. Isso ocorre porque os modelos não têm espaço para reconhecer pressupostos equivocados e corrigir informações distorcidas.

Outro ponto importante é que modelos preferidos pelos usuários nem sempre são os mais precisos. A OpenAI, por exemplo, enfrenta dificuldades para equilibrar respostas que atendam às expectativas dos usuários sem sacrificar a precisão factual.

Ainda mais, os pesquisadores concluem que a busca pela experiência otimizada pode prejudicar a veracidade. Isso cria um dilema entre oferecer respostas rápidas e garantir informações verdadeiras, especialmente quando os usuários apresentam questões com confiança ou baseadas em premissas incorretas.