Ferramentas de Inteligência Artificial estão sendo usadas para criar deepfakes de pessoas – a grande maioria mulheres e até crianças – em situações de abuso sexual.

Um relatório da Safernet aponta que a IA contribuiu para um recorde de denúncias de abuso infantil online no Brasil em 2023, com 71.867 novas denúncias. Thiago Tavares, fundador da Safernet, alerta que a produção de material de abuso infantil com IA já está sendo documentada globalmente.

A situação é grave e tem gerado respostas internacionais.

Nos Estados Unidos, o FBI acusou recentemente um homem de criar mais de 10 mil imagens de abuso sexual infantil usando IA.

Bertram Lyons, presidente da Medex Forensics, explica que a autenticidade das imagens geradas por IA desafia o sistema judicial e os investigadores, aumentando a carga de trabalho das autoridades.

Em 2023, o Centro Nacional para Crianças Desaparecidas e Exploradas (NCMEC) dos EUA registrou 4.700 denúncias de exploração sexual infantil gerada por IA.

Em resposta, o presidente Joe Biden propôs um compromisso para que a indústria de tecnologia crie barreiras contra a disseminação de imagens de abuso sexual geradas por IA.

Além dos problemas de abuso infantil, a manipulação de imagens com IA também se expandiu para o mercado paralelo.

Canais no Telegram oferecem serviços para criar deepfakes e fakenudes, cobrando valores baixos por fotos e vídeos manipulados.

Esses serviços permitem que qualquer pessoa pague para ver outra pessoa nua em vídeos falsos, alimentando um mercado perigoso e antiético.

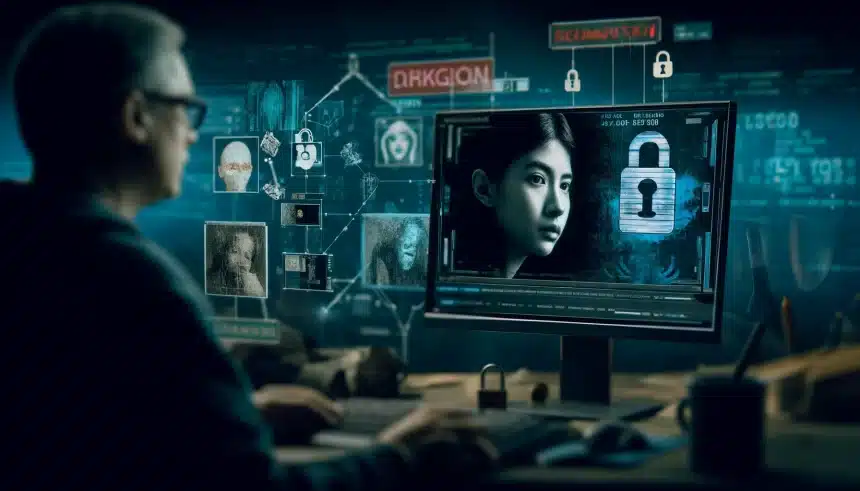

Autoridades apontam os desafios para identificar deepfakes

A crescente disponibilidade de modelos e ferramentas de IA facilitou a produção e venda de deepfakes, colocando um desafio significativo para as autoridades e aumentando a necessidade de medidas regulatórias para proteger as vítimas desses crimes cibernéticos.

Em entrevista recente ao portal O Globo, o delegado Everson Contelli, relata um aumento nos casos de manipulação de imagens por IA no Brasil.

Segundo ele, esses crimes são complexos e caros de resolver, pois envolvem identificar a veracidade das imagens manipuladas.

“O custo para a resolução do crime cibernético é muito maior, tanto de tempo quanto de dinheiro. Essas ferramentas podem confundir a investigação, que precisa primeiro identificar se as imagens são verdadeiras.”